英伟达CEO黄仁勋正式揭开了新一代AI平台Vera Rubin的神秘面纱。这一平台的定位与价值,被英伟达高性能计算与AI基础设施解决方案高级总监Dion Harris精准概括——它并非单一芯片,而是由六颗核心组件共同构建的“一台AI超级计算机”,专为云端与大型数据中心的下一代AI工作负载量身打造。

英伟达CEO黄仁勋正式揭开了新一代AI平台Vera Rubin的神秘面纱。这一平台的定位与价值,被英伟达高性能计算与AI基础设施解决方案高级总监Dion Harris精准概括——它并非单一芯片,而是由六颗核心组件共同构建的“一台AI超级计算机”,专为云端与大型数据中心的下一代AI工作负载量身打造。

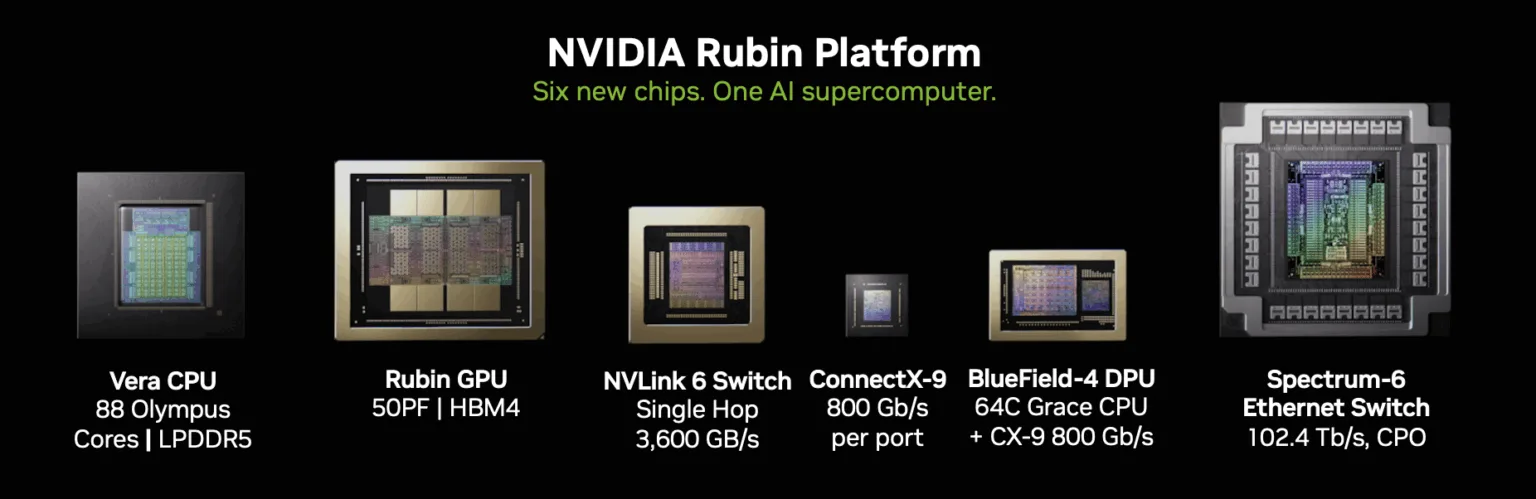

构成Vera Rubin平台的六大核心组件各司其职,共同搭建起强大的计算架构:包括负责通用计算的Vera CPU、承担图形与AI算力核心的Rubin GPU、保障高速互联的第六代NVLink交换芯片、实现网络连接的ConnectX-9网卡、优化数据处理的BlueField 4 DPU,以及支撑高带宽网络的Spectrum-X 102.4T CPO。其中,Rubin GPU的性能表现尤为亮眼,其搭载了第三代Transformer引擎,NVFP4推理算力达到50PFLOPS,这一数值是英伟达上一代Blackwell GPU的5倍,为AI推理任务提供了强劲动力。

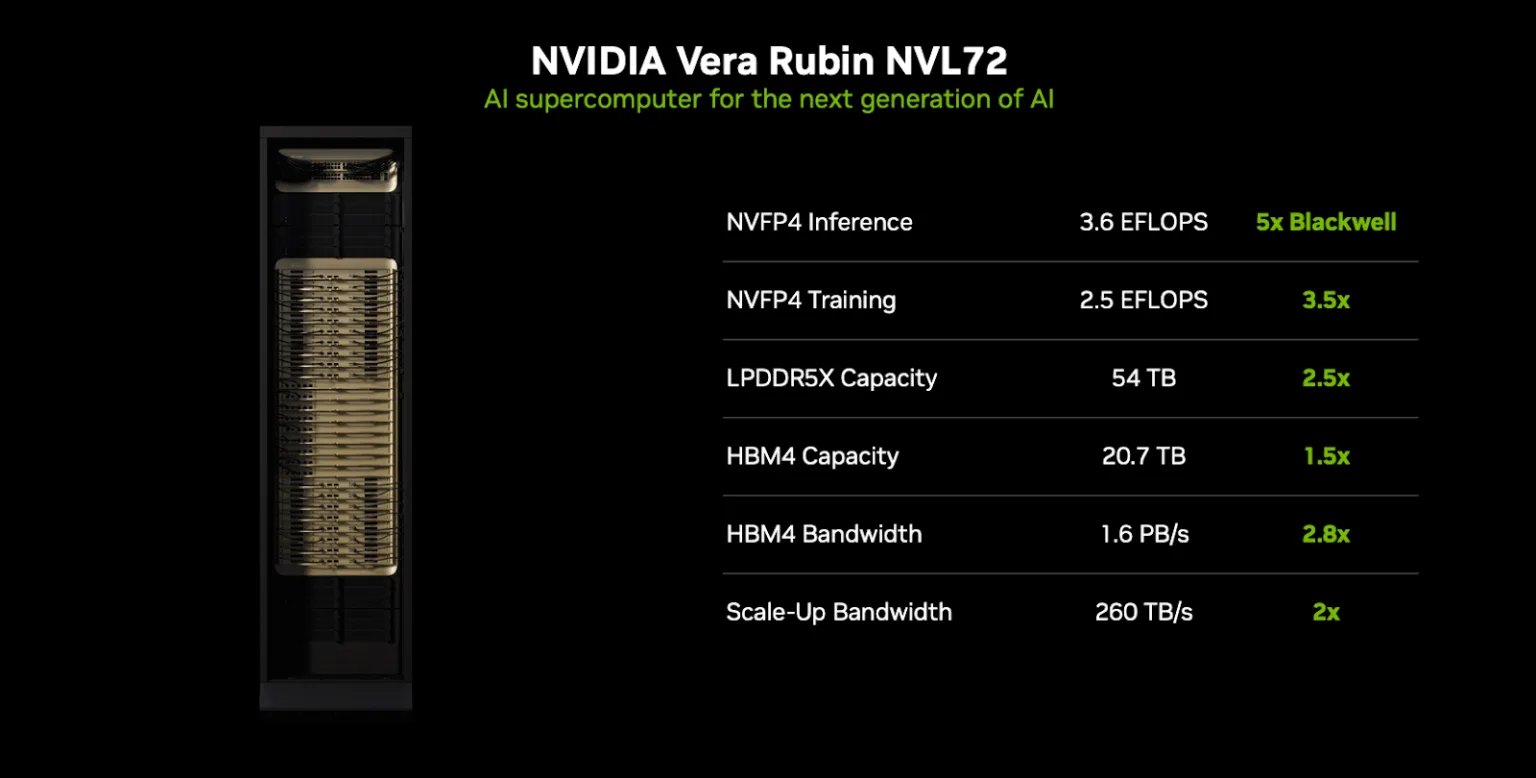

在整体架构效能上,Vera Rubin平台实现了“降本增效”的双重突破。面对超大规模“专家混合”(Mixture of Experts,MOE)模型的训练需求,该平台在相同训练时长下,仅需使用上一代产品四分之一数量的GPU;更关键的是,每个token的训练成本直接降至原来的七分之一,大幅降低了大型AI模型的研发与应用门槛。同时,英伟达着重强调了Vera Rubin在安全领域的突破——它将支持第三代机密计算技术,成为业界首个机架级可信计算平台,能够充分满足对安全隔离、数据隐私及多租户环境有高要求的AI场景需求。

事实上,Vera Rubin平台的研发与推出,源于英伟达对行业技术瓶颈的深刻洞察。随着摩尔定律逼近物理极限,晶体管密度对算力的边际贡献持续下降,单纯依靠增加晶体管数量提升性能的路径已难以为继。为此,英伟达早在2025年10月29日便推出了Vera Rubin超级芯片,其核心思路并非“堆砌硬件”,而是通过CPU与GPU的异构协同、搭配HBM4高带宽显存,再结合CUDA生态的兼容优势,以架构与系统级的创新实现算力的跨越式提升。

事实上,Vera Rubin平台的研发与推出,源于英伟达对行业技术瓶颈的深刻洞察。随着摩尔定律逼近物理极限,晶体管密度对算力的边际贡献持续下降,单纯依靠增加晶体管数量提升性能的路径已难以为继。为此,英伟达早在2025年10月29日便推出了Vera Rubin超级芯片,其核心思路并非“堆砌硬件”,而是通过CPU与GPU的异构协同、搭配HBM4高带宽显存,再结合CUDA生态的兼容优势,以架构与系统级的创新实现算力的跨越式提升。

在硬件形态与设计上,Vera Rubin计算架构同样进行了全面革新:采用第三代完全无缆化设计,摆脱传统线缆对布局与性能的限制;同时配备100%全液冷系统,高效解决高密度计算带来的散热难题,从连接方式到散热体系完成了全方位升级。以旗舰产品Vera Rubin NVL72机架式系统为例,其核心的Vera Rubin超级芯片由Rubin GPU与Vera CPU组成——Rubin GPU周边环绕大量电源电路,设有8个HBM4显存位点,且集成两颗Reticle尺寸的GPU芯片;Vera CPU则搭载88个定制ARM核心,总计可提供176个线程,为多任务处理提供充足资源。

从性能迭代脉络来看,英伟达芯片架构已完成从Hopper、Blackwell到Rubin的三代演进。作为Rubin架构下的旗舰产品,Vera Rubin超级芯片的VR200、VR300(Ultra)加速器展现出数倍于前代的性能:FP4算力分别达到50PFLOPS与100PFLOPS,显存配置覆盖288GB HBM4至1025GB HBM4E,显存带宽最高可达32TB/s;而CPU部分也从Grace系列升级至Vera系列,核心性能与线程数的双重提升,进一步释放了CPU与GPU异构协同的算力潜力,让整体计算效率再上台阶。

目前,英伟达Rubin平台已正式进入全面生产阶段,根据规划,基于该平台的相关产品将在2026年下半年通过合作伙伴陆续面市,为全球AI与高性能计算领域注入新的活力。